Afin de pouvoir relever les défis liés aux évolutions technologiques et pouvoir développer sa capacité à gérer avec rapidité et efficacité des données variées et dont le volume augmente de façon exponentielle, il est essentiel de définir une stratégie de gouvernance des données solide et cohérente.

Un standard international relatif à la gestion de la qualité des données

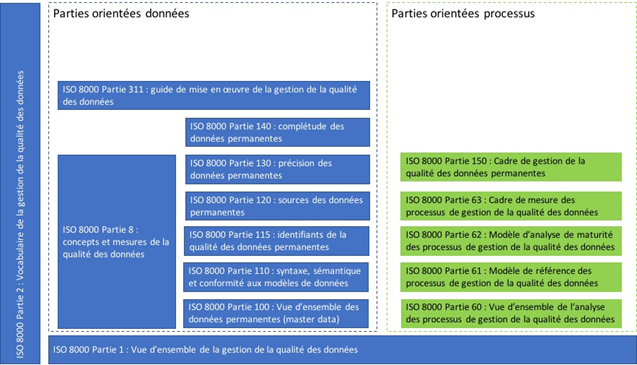

La norme ISO 8000 consiste en une série de standards relatifs à la gestion de la qualité des données et les exigences de mise en œuvre pour l’implémentation, l’échange de données et la provenance des données.

Ces standards contiennent également un cadre informatif qui identifie les processus de gestion de la qualité des données, qui peut être utilisé conjointement avec la norme ISO 9001 relative aux systèmes de gestion de la qualité.

Dans la ligne des normes ISO, il s’agit d’un cadre normatif international et reconnu, dont l’utilisation devient de plus en plus populaire auprès d’entreprises du Fortune 500 et d’agences gouvernementales. En l’adoptant, votre organisation s’assure ainsi de pouvoir bénéficier des meilleures pratiques concernant la gestion des données sur le long terme.

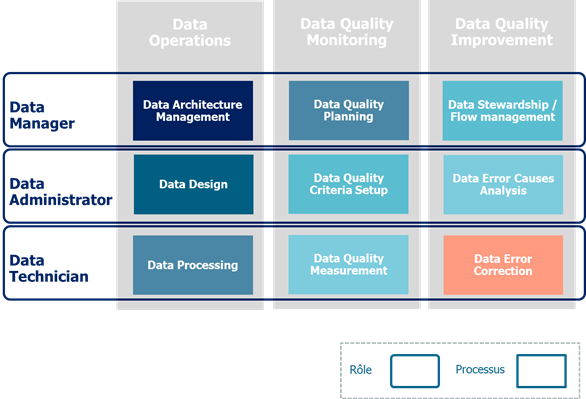

Ce-dessous, une présentation du modèle de gouvernance proposé par cette norme.

Ce modèle est divisé en trois processus verticaux et trois rôles horizontaux. Il s’agit d’un schéma simplifié qui sera sans doute plus complexen selon la taille de l’organisation. Toutefois, s’appuyer sur cette modélisation globale va nous permettre d’identifier les processus stratégiques, tactiques et opérationnels.

Description des processus

Data Operations

Les processus « Data Operations » se focalisent sur les facteurs qui influencent la qualité des données et l’usage des données :

- Data Architecture Management gère l’architecture des données de l’organisation ;

- Data Design gère les standards et les définitions des données, l’implémentation des bases de données et leur configuration ;

- Data Processing couvre les activités qui créent, modifient, mettent à jour et transfèrent les données.

Data Architecture management

Dans la plupart des organisations, les données sont distribuées à travers de nombreuses bases de données, ce qui signifie que la qualité des données ne peut être gérée de manière efficace si l’on n’adopte pas une démarche méthodologique pour le stockage des données.

Ce processus inclut entre autres les activités suivantes :

- Gérer les modèles de données conceptuels à l’échelle de l’organisation ;

- Gérer les normes et standards relatifs aux données à l’échelle de l’organisation, dont leur mise à jour à mesure que les exigences changent ;

- Gérer les interfaces et coordination entre les systèmes et les bases de données ;

- Définir l’utilisation des outils de gestion de données ;

- Définir les mesures garantissant l’accessibilité et la sécurité des données.

Data Design

Les erreurs de qualité de données sont soit dues aux erreurs des utilisateurs, soit dues à des erreurs de définition des données. Les erreurs des utilisateurs peuvent être corrigées relativement facilement, toutefois, les erreurs de définition des données peuvent être difficiles à résoudre, particulièrement si elles sont présentes depuis un moment.

Les activités clés liées de ce processus comprennent :

- Développer les modèles de données logiques et physiques ;

- Définir les normes et standards des données recueillies sur le terrain ;

- Avoir connaissance des exigences en matière de données découlant de l’approche globale du processus « Data Architecture Management » ;

- Consulter les autres parties prenantes pour comprendre la relation des données avec les autres systèmes et bases de données et consulter les utilisateurs pour s’assurer que les standards de données répondent aux exigences de qualité des données ;

- Maintenir les configurations des systèmes pour s’aligner avec des standards de données.

Data Processing

Les activités de ce processus concernent la création et mise à jour des données. Une gestion efficace de ces activités est essentielle pour être rapidement averti lorsque des problèmes de qualité de données sont présents dans le lac de données. Il s’agit – en utilisant une analogie – de continuellement vérifier que « l’eau entrante est propre ».

Les activités de ce processus comprennent :

- Monitorer les processus de création et de mises à jour de données ;

- Effectuer la journalisation de l’utilisation des données et des temps de mises à jour ;

- Avoir connaissance des différents rôles liés au traitement des données.

Data Quality Monitoring

Les processus « Data Quality Monitoring » définissent une approche systématique pour évaluer les niveaux de qualité des données :

- Data Quality Planning définit les objectifs de la gestion de la qualité des données de manière à ce qu’ils soient alignés avec les objectifs organisationnels ;

- Data Quality Criteria Setup définit les mesures et les méthodes pour évaluer la qualité des données ;

- Data Quality Measurement est le processus qui utilise ces critères de qualité des données pour évaluer les niveaux de qualité de données.

Data Quality Planning

Le processus « Data Quality Planning » définit les cibles qui permettent au processus « Data Quality Management » d’atteindre les objectifs organisationnels globaux. Cela consiste à s’assurer qu’il y a une approche cohérente de la qualité des données supportées par un Plan Qualité des Données détaillé.

Les activités de ce processus comprennent :

- Gérer les objectifs organisationnels liés à la qualité des données, en fonction des exigences internes et externes ;

- Gérer les procédures d’assurances qualité pour la gestion de la qualité des données

- Planifier les activités (tâches spécifiques, délais, ressources et budget) qui permettent de parvenir au niveau requis de qualité des données ;

- Contrôler les facteurs qui affectent la qualité des données ;

- Obtenir le soutien de la direction pour le Plan Qualité des Données.

Data Quality Criteria Setup

Pour pouvoir monter le Plan Qualité des Données, il faut être en mesure d’évaluer les niveaux actuels de la qualité des données. Cela implique la mise en place d’un certain nombre de Critères de Qualité des Données (également nommés Règles de Qualité des Données) qui détaillent les tests spécifiques permettant de déterminer la validité, l’exhaustivité, l’unicité et l’exactitude des données.

Les deux activités principales de ce processus sont :

- Identifier les Critères de Qualité des Données, les données cibles et la méthode de mesure ;

- Affiner les Critères de Qualité des Données en fonction des résultats de la mesure de la qualité des données.

Data Quality Measurement

Nous avons jusqu’à présent fixé les objectifs globaux de qualité pour l’organisation et avons développé les critères de qualité des données correspondants, mais nous n’avons pas encore évalué la qualité réelle des données. Le processus « Data Quality Measurment » utilise les Critères de Qualité des Données pour mesurer la qualité actuelle des données, ce qui peut être effectué manuellement ou à l’aide d’outils spécifiques.

Ce processus reçoit des informations du processus « Data Quality Criteria Setup » et fournit les paramètres d’entrée clés des processus « Data Error Cause Analysis » et « Data Error Correction ».

Data Quality Improvement

Les processus « Data Quality Improvement » corrigent les erreurs de données détectées et éliminent les causes racines des erreurs de données :

- Data Stewardship and Flow Management est le processus qui analyse les flux de données et les responsabilités et gère l’intendance des traitements de données (i.e. s’assurer que les données sont exactes, contrôlées, et faciles à découvrir et à traiter par les intervenants correspondants) ;

- Data Error Cause Analysis est le processus qui identfie les causes racines des erreurs de données dans le but de prévenir de nouvelles occurrences ;

- Data Error Correction est le processus qui corrige les données qui ne répondent pas aux standards ou aux critères de qualité des données.

Data Sterwardship / Flow Management

Les interactions des données avec les processus et la façon dont les données peuvent être partagées entre les systèmes et les bases de données rendent essentiel de comprendre comment les données circulent à travers une organisation pour pouvoir gérer efficacement leur qualité.

Les deux activités principales de ce processus sont :

- Définir qui peut accéder aux données et les modifier dans divers systèmes, c’est à dire l’attribution de l’intendance et la gestion continue de ces autorisations ;

- Etudier les flux de données afin de comprendre les relations entre des données identiques stockées dans différentes bases de données, et comment les changements dans une base de données devraient être répercutés vers les autres. Ceci est un élément de la gestion des données de référence et implique la coordination entre un certain nombre d’unités organisationnelles.

Les processus « Data Flow Management » et « Data Architecture Management » sont étroitement liés : l’un définit les relations entre les données et l’autre comment les données circulent entre elles.

Data Error Cause Analysis

En utilisant l’ancienne analogie selon laquelle vous perdriez votre temps à nettoyer l’eau d’une piscine si vous ne vous vous occupez pas d’abord de la source des problèmes, il en est de même pour les données : il est important d’identifier les causes racines des erreurs de données afin de pouvoir les résoudre avant de tenter de corriger les données.

Les deux activités principales de ce processus sont :

- Identifier et corriger les causes racines, ce qui consiste entre autres à développer des critères appropriés pour évaluer les erreurs de données afin d’éviter de perdre trop de temps dans l’analyse. Une fois la (ou les) cause(s) racine(s) identifiée(s), elles doivent être corrigées ;

- Analyser les autres systèmes et bases de données pour déterminer si ces causes racines pourraient également y être présentes, auquel cas elles devraient également être corrigées, afin d’aider à prévenir la récurrence des problèmes.

Ce processus est lié à un certain nombre d’autres processus de notre système de gouvernance ISO 8000 :

- Selon les causes d’erreur identifiées, il peut être nécessaire d’ajuster la gestion des données et les flux de données (processus « Data Sterwardship / Flow Management ») ;

- Afin de corriger les erreur de données, les données de sorties du processus « Data Error Cause Analysis » doivent être les données d’entrée du processus « Data Error Correction » ;

- Afin de réduire d’avantage le risque de récurrence, les données de sorties du processus « Data Error Cause Analysis » peuvent être des données d’entrée pour les processus « Data Quality Criteria Setup » et « Data Design ».

Data Error Correction

Les erreurs de données peuvent être identifiées à partir d’un certain nombre de sources, notamment les processus « Data Quality Monitoring » et « Data Error Cause Analysis ».

Les activités de ce processus comprennent :

- Définir les conditions de correction des erreurs de données : qui, quand et comment ;

- S’assurer, si nécessaire, que les corrections soient partagées avec les autres bases de données et parties prenantes.

Pour les deux activités ci-dessus, il est important de s’assurer que le personnel dispose de l’autorisation requise pour effectuer les corrections.

Description des rôles clés

Le standard définit également trois rôles génériques : Data Manager (gestionnaire des données), Data Administrator (adminitrateur des données) et Data Technician (technicien des données).

Ces rôles se partagent les activités stratégiques, tactiques et opérationnelles nécessaires pour développer et gérer le cadre de votre stratégie de gestion de la qualité des données. À la suite de l’audit, nous pourrons déterminer les obligations et responsabilités individuelles qui s’appliquent en fonction de l’organisation de Shom et s’assurer que le personnel comprend les attendus de chaque rôle.

Data Manager

Le Data Manager est responsable des facteurs organisationnels de la gestion de la qualité des données et du fonctionnement global du système de gouvernance.

Ce rôle implique la gestion des trois processus stratégiques :

- Data Architecture Management ;

- Data Quality Planning ;

- Data Stewardship/Data Flow Management.

Data Administrator

Le Data Administrator est responsable du contrôle et de la coordination du travail des Data Technicians et de l’alignement sur la direction définie par le Data Manager.

Ce rôle implique la gestion des trois processus tactiques :

- Data Design ;

- Data Quality Criteria Setup ;

- Data Error Cause Analysis.

Data Technician

En général, le Data Technician travaille directement avec les données, sous la responsabilité du Data Administrator, à travers les processus opérationnels suivants :

- Data Processing ;

- Data Quality Measurement ;

- Data Error Correction.

Analyse de l’organisation et des procédés en place

L’identification des écarts

Pour mettre en place l’ISO 8000 dans un organisme, nous travaillons par différentiel : à l’aide d’une checklist détaillée, nous évaluons le niveau de maturité de la structure avec les critères objectifs définis par la norme, à travers les huit domaines clés suivants :

- Gouvernance ;

- Organisation et personnes ;

- Processus ;

- Définition des exigences ;

- Métriques et dimensions ;

- Efficacité des processus ;

- Architecture, outils et technologies ;

- Normes de données.

Ci-dessous une description rapide des différents niveaux de maturité de chaque chapitre de notre checklist d’évaluation (initial, répétable, défini, géré, optimisé).

Ces critères sont basés sur le modèle CMMI, qui définit une échelle de mesure à cinq niveaux de la maturité d’une organisation, c’est à dire du degré auquel celle-ci a déployé explicitement et de façon cohérente des processus qui sont documentés, gérés, mesurés, contrôlés et continuellement améliorés.

1. Gouvernance

| 1- Initial | Au niveau initial, il n’y a pas d’objectifs formels, de procédures ou de gouvernance pour la qualité des données. Les responsabilités et les activités ne sont pas définies et la technologie est utilisée de manière ponctuelle pour résoudre tout problème de qualité des données. |

| 2- Répétable | Les meilleures pratiques reproductibles sont créées et publiées sur la base des expériences antérieures de résolution des problèmes de qualité des données. Il existe une approche ascendante de la qualité des données, où les individus concernés initient des recommandations pour les techniques, les processus et la gouvernance de la qualité des données. |

| 3- Défini | Des paramètres définis pour l’évaluation de la gouvernance de la qualité des données et des résultats de la qualité des données sont établis. Les rôles, les responsabilités et les processus sont systématiques et utilisés dans toute l’entreprise. |

| 4- Géré | Les mesures de gouvernance de la qualité des données et les besoin de l’entreprise sont intrinsèquement liés et les améliorations de la qualité des données sont priorisés en fonction des critères définis par l’organisation. |

| 5- Optimisé | Au niveau optimisé, la gouvernance de la qualité des données est une composante systématique de la gestion des données et de la gouvernance de l’information, et étroitement alignée sur les objectifs stratégiques de l’organisation. Des améliorations continues sont en place et l’organisation utilise une analyse comparative de la qualité des données pour étudier les possibilités d’améliorations supplémentaires. |

2. Organisation et personnes

| 1- Initial | Au niveau initial, les rôles et responsabilités formels ne sont pas définis et il existe des réponses réactives aux problèmes de qualité des données au fur et à mesure qu’ils surviennent. Il n’y a pas de culture de la qualité des données. |

| 2- Répétable | Les rôles et compétences techniques et opérationnels sont regroupés au niveau du département ou de la branche d’activité. Dans certains domaines d’activité, les responsabilités en matière de gestion des données sont plus formalisées et décrites. Certains des besoins en capacités de l’organisation sont satisfaits et des ébauches de descriptions des connaissances et des besoins en capacités sont en place. Une première version d’une feuille de route pour établir une culture de la qualité des données est en place. |

| 3- Défini | Les rôles opérationnels formels et la structure organisationnelle sont définis, y compris un rôle dédié au nettoyage des données responsable de la qualité des données qui garantit que les données sont mesurées, nettoyées et rendues aussi adaptées à l’utilisation que possible. Le rôle peut être intégré dans des titres de poste officiels tels que « data analyst » ou « data scientist ». Les problèmes de qualité des données sont rigoureusement suivis par des rôles désignés, et l’organisation inclut la gestion des risques pour la qualité des données. Des activités et des objectifs sont en place pour assurer une culture de qualité des données. Les exigences en matière de connaissances et la capacité du personnel sont décrites et des activités sont en place pour répondre à la plupart des besoins. Des changements de culture et des activités sont en place conformément à la feuille de route, et des mesures de la qualité de la culture des données sont effectuées. |

| 4- Géré | La collaboration inter fonctionnelle est en place, y compris entre les différentes équipes, et elle joue un rôle essentiel dans la maximisation de la valeur des données. Le rôle chargé du nettoyage des données garantit que les données restent utilisables tout au long de leur cycle de vie, tandis que les responsables des données sont toujours impliqués dans les efforts d’amélioration de la qualité des données. L’évaluation des risques des données est effectuée en amont. Les activités liées la qualité des données sont alignées sur les autres activités orientées gestion de la qualité (ISO 9001, etc.) et les progrès sont mesurés dans le cadre d’une vue d’ensemble. Les besoins et l’accès aux connaissances et aux ressources sont gérés et des prévisions des besoins futurs sont en place. La connaissance formalisée est intégrée dans les algorithmes et l’automatisation. |

| 5- Optimisé | Au niveau optimisé, l’innovation devient essentielle pour maintenir la vision de l’amélioration de la qualité des données et de la résolution des problèmes de qualité des données. Le personnel de gestion et de gouvernance des données se tient au courant des nouvelles tendances importantes dans la gestion de la qualité des données et s’adapte en conséquence. Des boucles de rétroaction sur la culture de la qualité des données sont en place. Les actions proactives et correctives liées à la culture font partie de la vie quotidienne. La gestion de la connaissance se fait continuellement avec une saisie au cours des activités quotidiennes et rendues accessibles aux collègues. Un niveau élevé de connaissances formalisées est intégré dans les algorithmes et l’automatisation. Les connaissances formalisées sont transparentes, testées et vérifiées. |

3. Processus

| 1- Initial | Au niveau initial, tous les problèmes de qualité des données sont traités de manière ponctuelle et réactive avec un manque de traçabilité et se concentre sur les symptômes plutôt que sur la cause racine. |

| 2- Répétable | Les procédures sont souvent manuelles et exécutées de manière répétée, sans communication avec les processus associés en amont ou en aval de l’incident lié à la qualité des données. Les erreurs simples reproductibles peuvent être recherchées et la cause racine peut être résolue de manière permanente. Un support de processus rudimentaire et des historiques d’audit pour les données manquantes et les erreurs de format sont disponibles. |

| 3- Défini | Les processus de qualité des données sont définis et documentés et sont capables d’identifier et de suivre automatiquement les problèmes de qualité des données plus complexes. Les processus sont mis en œuvre au niveau de l’entreprise et toutes les activités d’atténuation nécessaires sont spécifiées et communiquées à l’unité ou à la personne responsable. |

| 4- Géré | Tous les processus de qualité des données sont définis par des politiques et une gouvernance et sont exécutés de manière proactive. La nature proactive tire parti de la détection précoce des problèmes de qualité des données et d’un bon contrôle des dommages. |

| 5- Optimisé | Au niveau optimisé, l’objectif principal des processus de qualité des données est de faciliter le cycle d’amélioration continue. Il est possible de se baser sur toute méthodologie adoptant le « Plan / Do / Check / Act » et elle pourrait être formalisée par des normes telles que ISO 9000. Tous les aspects des processus doivent être mesurés, audités et communiqués. |

4. Définition des exigences

| 1- Initial | Au niveau initial, il n’y a pas d’attentes articulées quant à la qualité des données. Les données brutes sont introduites dans le système sans tenir compte des problèmes potentiels de qualité des données. |

| 2- Répétable | Les problèmes de qualité des données syntaxiques de base répétables sont découverts et signalés. Des exemples de problèmes pouvant être identifiés sont les valeurs hors limites, les formats de données non valides, etc. Les exigences ne sont pas formellement énoncées mais peuvent être déduites de domaines et de contextes. |

| 3- Défini | Les définitions des exigences relatives aux données définies sont clairement énoncées et formalisées. Les règles de qualité des données pour la conformité syntaxique et sémantique sont documentées et prises en charge par des méthodes et des technologies. Les exigences sont clairement liées aux impacts opérationnels. |

| 4- Géré | La conformité avec les définitions des exigences en matière de données est évaluée à intervalles réguliers en tant que partie intégrante du processus d’intégration des données. Les exigences sont définies comme une composante des politiques et de la gouvernance de la qualité des données. L’impact opérationnel est utilisé comme guide pour hiérarchiser les activités afin d’assurer la conformité aux attentes de définition des données. |

| 5- Optimisé | Au niveau optimisé, les définitions des exigences en matière de données sont liées aux objectifs d’amélioration de l’organisation en tant que partie intégrante d’un cycle d’amélioration continue. Les valeurs de références sont définies et les effets de l’amélioration sont mesurés par rapport à ces valeurs de références. Les objectifs de l’organisation sont utilisés pour modifier les définitions des exigences et les rôles sont définis pour attribuer la responsabilité du suivi et de la collecte des modifications des exigences. |

5. Métriques et dimensions

| 1- Initial | Au niveau initial, il n’y a aucune incitation et aucun paramètre défini pour mesurer la qualité des données. Les problèmes de qualité des données ne sont pas classés en fonction de leur nature générale et il n’y pas de cadre cohérent pour classer les problèmes de qualité des données en place. |

| 2- Répétable | Les problèmes de qualité des données reproductibles sont reconnus et classés en fonction des dimensions de la qualité des données, telles que la cohérence, l’intégrité, la fiabilité et l’intégrité. Des règles de qualité des données sont définies et la conformité des valeurs des données est mesurée selon les dimensions définies. |

| 3- Défini | Les métriques et les dimensions de la qualité des données sont clairement définies et les exigences de qualité syntaxique et sémantique des données sont spécifiées. Les règles de qualité des données sont définies et vérifiées pour la qualité des données syntaxiques et sémantiques et la qualité des données est validée de manière concrète. Les résultats sont communiqués par des rapports sur la qualité des données. |

| 4- Géré | Les mesures de la qualité des données sont conformes aux politiques et à la gouvernance de l’organisation, et les impacts organisationnels liés aux effets de la non-conformité sont évaluables. Des rôles sont établis pour gérer les réponses aux problèmes de qualité des données et les définitions et mises à jour des métriques et des dimensions. |

| 5- Optimisé | Au niveau optimisé, les métriques et dimensions de la qualité des données sont liées au SLA spécifiant des valeurs de seuil pour les actions d’atténuation pertinentes. La définition et la maintenance des métriques de qualité des données font partie intégrante du développement du système informatique, garantissant une réponse proactive aux problèmes de qualité des données. |

6. Efficacité des processus

| 1- Initial | Au niveau initial, l’organisation travaille de manière réactive, en utilisant les défaillances du système et des opérations causées par la qualité des données comme déclencheurs des activités de qualité des données. La qualité des données n’est pas surveillée. |

| 2- Répétable | Les mesures génériques reproductibles de la qualité des données sont effectuées par profilage, et certaines zones d’impact sont définies et liées aux mesures de profilage. La réingénierie est déployée pour fournir des informations sur des mesures de qualité des données plus spécifiques. |

| 3- Défini | L’impact opérationnel des problèmes de qualité des données est analysé et des dispositifs de mesure sont en place pour détecter les problèmes de qualité des données bien avant les défaillances qui en résultent. Tous les problèmes de qualité des données découverts et les résolutions pertinentes sont suivis de manière systématique. Des outils technologiques pour mesurer la qualité des données sont en place. |

| 4- Géré | Les mesures de la qualité des données sont publiées dans le cadre des rapports de performance de l’organisation et affichées dans des tableaux de bord de qualité des données montrant le Data Quality Index (DQI), le statut et les tendances. Les rapports sont communiqués et accessibles aux parties prenantes concernées, en mettant l’accent sur les impacts négatifs sur les activités. |

| 5- Optimisé | Au niveau optimisé, les mesures de la qualité des données sont dynamiques et peuvent être mises à jour par les utilisateurs métier en réponse aux modifications de politique et de gouvernance. Les mesures sont utilisées activement pour suggérer des activités de qualité des données, assurant ainsi un soutien à l’amélioration continue. |

7. Architecture, outils et technologies

| 1- Initial | Au niveau initial, aucune technologie formelle n’est disponible pour effectuer des tâches liées à la qualité des données. Des outils sont développés en interne pour résoudre des problèmes spécifiques à des ensembles de données particuliers. Aucune architecture cohérente ou évolutive de l’organisation n’est implémentée. |

| 2- Répétable | Des outils prenant en charge les activités de qualité des données, tels que le profilage, l’analyse, le nettoyage, la réingénierie ou le découplage, sont disponibles et partiellement mis en œuvre au niveau reproductible. La technologie est utilisée sur une base individuelle et ne suit aucune bonne pratique. |

| 3- Défini | Les meilleures pratiques d’utilisation de la technologie de qualité des données sont en place et communiquées. Les outils prennent en charge la validation des règles métier et la conformité aux normes. La technologie est intégrée et exécutée dans le cadre de l’infrastructure IT. |

| 4- Géré | La technologie de qualité des données suit des directives, une architecture, des objectifs et une gouvernance définis, et recherche un degré élevé d’automatisation dans la correction des données selon les règles métier et les données de référence. L’analyse de la qualité des données peut être effectuée à plusieurs étapes en amont et en aval dans les chaînes de valeur. Les analyses peuvent être effectuées en temps réel, par exemple, sur un flux continu de données. Les résultats de l’évaluation sont visualisés et communiqués par des tableaux de bord et des rapports à l’échelle de l’organisation. |

| 5- Optimisé | Au niveau optimisé, les outils de qualité des données sont utilisés comme partie intégrante du cycle d’amélioration continue, offrant aux utilisateurs métier peu de contraintes pour ajuster les règles de qualité des données et évaluer les impacts sur les performances. La gestion des modifications est utilisée pour suivre les modifications apportées à l’ensemble de règles. Les connaissances et algorithmes formalisés sont transparents, testés et vérifiés. |

8. Normes de données

| 1- Initial | Au niveau initial, les normes pour les définitions de métadonnées, l’interopérabilité, la qualité, la sécurité ou d’autres processus, techniques, protocoles ou éléments architecturaux liés à la qualité des données ne sont pas définis. Il peut y avoir des valeurs de données incohérentes en interne dans les ensembles de données, ainsi qu’entre les ensembles de données associés. |

| 2- Répétable | Des normes de données pertinentes sont identifiées et des lignes directrices pour la mise en œuvre des normes sont élaborées au niveau reproductible. Les exigences relatives aux métadonnées sont spécifiées pour l’identification des ensembles de données, comme indiqué dans la Dublin Core Metadata Initiative ou l’équivalent. |

| 3- Défini | Les normes identifiées au niveau reproductible sont entièrement mises en œuvre au niveau défini pour assurer la cohérence et la traçabilité. Des normes internes à l’organisation pour l’interopérabilité sont en place. |

| 4- Géré | Toutes les normes opérationnelles sont régies au niveau de l’organisation et toutes les exigences sont communiquées aux propriétaires de données. La responsabilité globale de la maintenance et de la conformité aux normes est clairement définie au sein de l’organisation et est mise en œuvre en tant que partie intégrante de l’infrastructure IT. Des normes pour la gestion de la chaîne de valeur des données et du cycle de vie sont en place. |

| 5- Optimisé | Au niveau optimisé, toutes les données définies par les normes et les processus associés sont traitées automatiquement et prises en charge par les politiques et la gouvernance. Les opportunités d’amélioration par la mise en œuvre de normes sont intégrées dans la gouvernance et sont soutenues par une taxonomie mondiale des normes de données. |

La définition du plan d’action

Suite aux résultats de l’audit, un plan d’action sera défini et présentera les travaux nécessaires pour combler l’écart entre la maturité réelle et la maturité cible de la structure selon la norme ISO 8000.

Ce plan d’action s’appuiera sur les directives précises et les bonnes pratiques décrites dans la norme pour faire évoluer l’organisation de la structure vers le système de gouvernance des données de l’ISO 8000.

L’ISO 8000 permettra de modéliser le fonctionnement de l’organisation en s’appuyant sur les processus de gestion de la qualité des données, sur la description des fonctions stratégiques, tactiques et opérationnelles et sur les comités de pilotage et indicateurs présentés dans la norme.